Po długiej przerwie blog wraca do życia. Rozpoczynamy serią artykułów filozoficznych na temat przyszłości IT i naszej cywilizacji mocno powiązanej z Technologią. Tytuł serii jest nieprzypadkowy, nawiązuje do monologu Neila deGrasse Tysona który zastanawiał się czemu ludzkość przestała stawiać sobie wielkie wyzwania topiąc się w kałuży swoich problemów. My także się nad tym zastanowimy na swój specyficzny techvortalowy sposób. Na pierwszy ogień idzie mój artykuł na temat katastrofy jaka może się nam w zdarzyć przyszłości, kiedy mocno uzależniona od nowoczesnej techniki cywilizacja zetknie się z problemem braku odpowiednio wykwalifikowanych kadr będących pchać ją do przodu. Zapraszam do czytania.

Po długiej przerwie blog wraca do życia. Rozpoczynamy serią artykułów filozoficznych na temat przyszłości IT i naszej cywilizacji mocno powiązanej z Technologią. Tytuł serii jest nieprzypadkowy, nawiązuje do monologu Neila deGrasse Tysona który zastanawiał się czemu ludzkość przestała stawiać sobie wielkie wyzwania topiąc się w kałuży swoich problemów. My także się nad tym zastanowimy na swój specyficzny techvortalowy sposób. Na pierwszy ogień idzie mój artykuł na temat katastrofy jaka może się nam w zdarzyć przyszłości, kiedy mocno uzależniona od nowoczesnej techniki cywilizacja zetknie się z problemem braku odpowiednio wykwalifikowanych kadr będących pchać ją do przodu. Zapraszam do czytania.

Koło historii

Historia lubi zataczać koło, a każda cywilizacja kiedyś się kończy…

Jesteśmy częścią pierwszego w pełni zinformatyzowanego pokolenia. Wielu z nas nie potrafiłoby wrócić do czasów, w których wiadomości ze świata przychodziły do nas z jednodniowym opóźnieniem spowodowanym cyklem dystrybucyjnym prasy; w którym nie moglibyśmy przekazać przez smartfona ukochanej osobie, że spóźnimy się na umówioną kolację, bo złapał nas ogromny korek; w którym na ulubioną piosenkę czy audycję musielibyśmy czekać godzinami przy radiu, bo YouTube, Netfliksa i Spotifaja jeszcze nie ma. Jako przykład można podać jeden z materiałów z programu śniadaniowego ogólnopolskiej telewizji, gdzie prowadzący poprosił o wyszukanie informacji w papierowej encyklopedii PWN młodzież z przełomu szkoły podstawowej i gimnazjum. [1]

Zbytnio przyzwyczailiśmy się do łatwości dostępu do szeroko pojętej informacji, małe komputery zawładnęły naszym życiem i są wszędzie – w naszych teczkach, kieszeniach, na rękach w postaci zegarka, regulują nasz piekarnik, sterują centralnym ogrzewaniem a często także procesami życiowymi. Jednak ludzkość lubi zataczać koło i wracać do momentu, w którym już kiedyś się znalazła. Przykład i tym razem będzie bolesny – otóż Oxford Dictionaries jako słowo roku 2015 wybrało…

…emoji[2], czyli po prostu swoistą emotikonkę. Z roku na rok coraz więcej młodych ludzi staje się wyedukowanymi w dwóch dialektach – w czystej ojczystej polskiej mowie oraz w internetowej mieszaninie hieroglifowo-angielsko-polskiej. Otóż wracamy do punktu wyjścia, w którym staliśmy kilka tysięcy lat temu, gdy na egipskiej pustyni wznoszono specyficzny typ grobowców zwany piramidami. Gdyby Oxford Dictionaries istniało wtedy, słowo roku mogłoby wyglądać tak:

…emoji[2], czyli po prostu swoistą emotikonkę. Z roku na rok coraz więcej młodych ludzi staje się wyedukowanymi w dwóch dialektach – w czystej ojczystej polskiej mowie oraz w internetowej mieszaninie hieroglifowo-angielsko-polskiej. Otóż wracamy do punktu wyjścia, w którym staliśmy kilka tysięcy lat temu, gdy na egipskiej pustyni wznoszono specyficzny typ grobowców zwany piramidami. Gdyby Oxford Dictionaries istniało wtedy, słowo roku mogłoby wyglądać tak:

lub tak: .[3]

Czy młodzież jest zainteresowana informatyką?

Jednak nie to jest najgorsze – język się zmienia i będzie zmieniał, sami nie potrafilibyśmy porozumieć się z naszymi praprapradziadkami z czasów wojny z Krzyżakami – tylko sam fakt, że nasze pokolenie było żywo zainteresowane samą informatyką i komputerami. Nie traktowaliśmy tego jako głównego wyznacznika naszego życia, lecz jako narzędzie, jedno z wielu, które trzeba dobrze poznać, znać jego mechanikę i sposób działania. Byliśmy do tego niejako zmuszeni, bo liczba oprogramowania dostępnego wówczas była znacząco mniejsza – z różnych powodów.

Przy braku dostępu do Internetu, który jest pokaźną skarbnicą wiedzy i programów, względnie niewielkiej przenośności danych (najczęściej na dyskietkach 1.44MB) w porównaniu do posiadanych dysków oraz niskiej liczbie czasopism branżowych i fachowców zajmujących się drogimi wówczas komputerami każdy z ówczesnych posiadaczy elektronicznej maszyny cyfrowej – jak do lat lat 70. nazywano komputer – starał się poznawać specyfikę i sposób działania posiadanego sprzętu na własną rękę. Tym oto sposobem od najmłodszych lat tworzyła się w nas informatyczna „zajawka”, która wypuściła od lat 80. zeszłego stulecia do lat 10. obecnego całą rzeszę informatyków, którzy napędzają i jeszcze długo będą napędzać rynek i przyśpieszać postęp technologiczny ludzkości[4].

Niewątpliwie przedstawiciele innych zawodów niż informatycy dostają szału gdy robiąc poranną prasówkę czytają o ciągłym wzroście płac w sektorze ICT, szczególnie, że jest znaczny deficyt pracowników w tej gałęzi usług, który będzie się znacząco pogłębiał. Już teraz w Stanach Zjednoczonych brakuje 300 tys. osób, a przewidywany brak rąk do pracy przy maszynach cyfrowych wyniesie w roku 2020 około miliona osób.[5] Pojawia się jednak następujące pytanie: czy młody człowiek kończący gimnazjum właściwie chce zostać informatykiem?

W tym miejscu trzeba wyjść sprzed biurka, przestać czytać twierdzenia analityków i po prostu rozejrzeć się po najbliższej okolicy.

Zwróćmy uwagę na ilość posiadanych telefonów komórkowych przez dzieci w wieku gimnazjalnym. Większość z nich posiada nie tyle komórkę, co smartfona – multimedialne urządzenie zdolne do łączenia się z Internetem. W Wielkiej Brytanii 7 na 10 dzieci w wieku 12-15 lat w kieszeni trzyma właśnie takie urządzenie![6] Co ciekawe, Polska wcale nie wypada w kwestii informatyzacji społeczeństwa gorzej od krajów „starej Unii” – co można potwierdzić prostym wyjazdem za granicę chociażby do Francji, gdzie dla przykładu płatności on-line są niezwykle niepopularne i przypominają polskie systemy bankowości elektronicznej z końca lat 90[7] [8]– stąd też dla uogólnienia przyjmijmy, że także i w Polsce 70% gimnazjalistów posiada smartfona.

Warto się teraz zastanowić – czy dzieci te interesują się urządzeniami z własnych kieszeni, czy są jedynie odbiorcami przekazywanych przezeń treści? Z całą stanowczością można powiedzieć, że zdecydowanie króluje druga opcja.

Bardzo podobnie dzieje się przy komputerach – służą one jedynie do komunikacji przez Facebooka, oglądania kotów oraz innych, okołoprokreacyjnych celów (co trzeci gimnazjalista odwiedza strony erotyczne). Rzadko który nastolatek interesuje się tym, jak to wszystko działa. Zdecydowanie częściej odbiera bądź kreuje proste treści wysyłane do Internetu, a w przypadku wystąpienia problemów technicznych – prosi starszego brata (który pamięta jeszcze czasy, w których nie było łącza szerokopasmowego i trzeba było być zaradnym) o pomoc.

Czy takie dziecko będzie zainteresowane informatyką? Nie, podobnie jak wielu z nas nie interesuje się naprawami sprzętu audio, co kiedyś było równie popularne[9] – tyle że brak specjalistów od RTV nie przyniesie tak katastrofalnych skutków, jak brak specjalistów od ICT.

Brak specjalistów

Już teraz ciężko znaleźć dobrego specjalistę z zakresu informatyki, a co dopiero skutecznego programistę. Do udowodnienia tej tezy z pewnością nie trzeba załączać obszernej bibliografii – wystarczy pójść na pierwsze-lepsze targi pracy odbywające się w dużym mieście – z kronikarskiego obowiązku jednak wypada podać ciekawy przykład, czyli ostatnie targi tylko (!) dla branży ICT w listopadzie 2015 na Stadionie Miejskim we Wrocławiu[10].

Tym oto sposobem mamy ogromny popyt na informatyków przy niskiej podaży. Cóż – muszą zadziałać prawa rynku. Korporacje z braku innych możliwości biorą już studentów pierwszego roku na staże, podczas których „dokształca” się ich zgodnie z własnymi potrzebami. „Dokształca”, tzn. używa się ich podobnie jak buty – kiedy się zniszczą jedne, wyrzuca się je i bierze kolejne. Specjaliści ICT to podwójny towar.

Z całą stanowczością możemy stwierdzić, że społeczeństwo złożone z ogólnie pojętego[11] zbioru homo corporatus jest już ogromnym zagrożeniem. Spójrzmy na Koreę Płd. bądź też Japonię – społeczeństwa starzejące się, wyniszczone wieloletnią pracą, ogarnięte samotnością[12] i falą samobójstw bądź śmierci z przepracowania.[13] Choć są to kraje odległe, to pewne negatywne cechy pracy w korporacjach są wspólne niezależnie od szerokości i długości geograficznej. Nie będziemy się jednak nad tym skupiać szerzej, to zdecydowanie temat na zupełnie odrębną pracę naukową.

Narastająca niechlujność

Już teraz mamy pewien problem z rozwojem sektora ICT. Często kod jest pisany „na kolanie”, by tylko szybko zapełnić konsumencką potrzebę, która się pojawiła gdzieś w oddali na horyzoncie. Czy ktoś w tych czasach dba o optymalizację swojego kodu? Jedynie nieliczni. Pojawia się tutaj pewien cykl, z którego niezwykle cieszą się z kolei producenci sprzętu komputerowego. Brak optymalizacji wymusza wejście na rynek konsumencki nowej generacji procesorów, kart graficznych, pamięci RAM itd. – co jednocześnie łechcze programistów do tworzenia jeszcze mniej zoptymalizowanego kodu, bazującego na starym. Czasem zdarza się, że po kilku latach firmy zauważają swój błąd i postanawiają przepisać swój produkt na nowo. Jako przykład problemów optymalizacyjnych można podać komentarz jednego z użytkowników vortalu technologicznego (pisownia oryginalna):

Niemniej makaron zdarza się każdemu. Pracowałem np. w firmie, która produkuje oprogramowanie chyba od 20 lat i choć wiadomo, że kod jest nieco kaszana, ale robi co ma i nikt teraz tego nie tknie (choćby aby unowocześnić kod), aby soft nie zawalił się jak domek z kart. Niemniej kod jest zamknięty, no to nikt go nie widzi, zatem sprawy „nie ma”. Podejrzewam, że tak bywa częściej – choćby dlatego, że pewnie ilu by nie zajrzało w kod, tak większość chciałaby go poprawić po swojemu, zatem nikt nie rusza tego, co działa.[14]

Z dokumentacją tworzonych programów i bibliotek wcale nie jest lepiej. Każda osoba, która musiała dopisać kilka linijek kodu w czyimś programie bądź skorzystać z procedur w zaimportowanej bibliotece doskonale wie, że bez niej jest to może nie tyle niemożliwe, co ogromnie czasochłonne. Pośpiech związany z tworzeniem nowego oprogramowania i próby gonienia postępu, który sami rozpętaliśmy odbija się nie tylko na marnym kodzie, jak także na braku bądź niekompletnej dokumentacji oraz specyfikacji i wielu przerwanych w połowie bądź zarzuconych projektach, na których bazuje masa aplikacji.

Gonitwa za rozwojem

Rozwój niezwykle pożytecznych technologii jest okupiony zmuszeniem ludzkości do biegu i nieustannego multiplikowania swoich umiejętności i wiedzy.

W latach 1970–2000 nastąpiło ośmiokrotne powiększenie zasobów wiedzy ludzkiej. Obecnie jeden numer poważniejszego dziennika czy tygodnika (np. „Gazety Wyborczej”, „Dziennika Polskiego”, „Naszego Dziennika”, „Newsweeka”, „Przekroju”, „Polityki”, „Niedzieli” etc.) zawiera tyle informacji, ile człowiek żyjący w XVIII wieku poznawał w ciągu całego życia.

Z jednej strony przeżywamy przyspieszony rozwój wiedzy, ale z drugiej równie szybkie jej starzenie się. Analiza literatury naukowej ostatniego półwiecza pozwala stwierdzić, że wiedza podwaja się średnio co 8 lat, a starzeje co 10 lat. Są dyscypliny, np. informatyka, telekomunikacja, inżynieria genetyczna, nanotechnologie, gdzie wiedza podwaja się co 3–4 lata. W literaturze amerykańskiej jeszcze 15 lat temu czytaliśmy, że każdy człowiek, chcąc utrzymać się na odpowiednim poziomie merytorycznym, musi 8 razy w życiu dokształcać się tak, jak gdyby zdobywał nowy zawód. Dzisiaj czytamy, że wspomniana liczba dokształceń wzrosła do 12. Edukacja ustawiczna staje się już nie postulatem, ale wyzwaniem – zawodowym „być albo nie być”.[15]

Ludzki mózg posiada ograniczenia, nie wspominając o innych organach. Czy my – przyszli młodzi informatycy – jesteśmy w stanie aż dwanaście razy w ciągu swojego życia całkowicie od początku rewidować własną wiedzę, zważywszy na to, że każda kolejna rewidencja nie będzie łatwiejsza, a wręcz przeciwnie?

Do nieustannego pomnażania wiedzy potrzebna jest dawka świeżej krwi – pasjonatów, ludzi „z zajawką”, mających zadatki na specjalistów.

Podsumowanie – czy sami sobie zaciskamy pętlę na szyi?

Podsumujmy więc dotychczasowe rozważania, które moglibyśmy rozciągnąć jeszcze na wiele godzin żywej dyskusji:

Mamy coraz mniej autentycznie chętnych na bycie informatykami. Można to dostrzec patrząc na listy przyjętych do techników informatycznych, które z roku na rok są coraz słabsze (tzn. coraz mniejsza liczba punktów jest wymagana do dostania się do takiej szkoły). Niewątpliwie część osób wybierze właśnie ten kierunek ze względów pragmatycznych (pewność zatrudnienia) – jednak można pokusić się o subiektywne stwierdzenie, że pragmatyk nie będzie tak dobrym informatykiem jak człowiek pełen pasji który wie, że to jest z pewnością jego dziedzina i w niej właśnie chce się realizować. De facto więc liczba informatyków „świeżej krwi” będzie się zmniejszać, co dodatkowo pogłębia kryzys demograficzny i słabnące echa wyżów z lat 50. i 80[16].

Mamy coraz mniej autentycznie chętnych na bycie informatykami. Można to dostrzec patrząc na listy przyjętych do techników informatycznych, które z roku na rok są coraz słabsze (tzn. coraz mniejsza liczba punktów jest wymagana do dostania się do takiej szkoły). Niewątpliwie część osób wybierze właśnie ten kierunek ze względów pragmatycznych (pewność zatrudnienia) – jednak można pokusić się o subiektywne stwierdzenie, że pragmatyk nie będzie tak dobrym informatykiem jak człowiek pełen pasji który wie, że to jest z pewnością jego dziedzina i w niej właśnie chce się realizować. De facto więc liczba informatyków „świeżej krwi” będzie się zmniejszać, co dodatkowo pogłębia kryzys demograficzny i słabnące echa wyżów z lat 50. i 80[16].

Co Ci przyszli młodzi specjaliści dostaną od nas w spadku?

Dostaną ogromne tempo potęgowania się wiedzy, któremu nie będą w stanie dorównać. W dodatku ta wiedza będzie nieudokumentowana, a problemy będą się piętrować.

Ci nieliczni informatycy będą mieli naprawdę pod górkę.

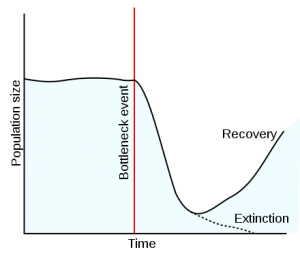

W biologii (a ściślej: w naukach o ewolucji) istnieje termin zwany bottleneck – efekt wąskiego gardła. Efekt ten pojawia się, gdy następuje kataklizm bądź katastrofa, a rozróżnienie populacji jest niewielkie. Liczebność populacji po katastrofie zmniejsza się, zawęża się pula dostępnych genów, gatunek stoi na rozdrożu.[17]

Na wykresie mamy zależność populacji od czasu, czerwoną linią oznaczono nasze wąskie gardło. Populacja ma możliwość znacząco wzrosnąć i odrodzić się, bądź też wyginąć.

Na wykresie mamy zależność populacji od czasu, czerwoną linią oznaczono nasze wąskie gardło. Populacja ma możliwość znacząco wzrosnąć i odrodzić się, bądź też wyginąć.

Ciężko powiedzieć, co może wywołać taką katastrofę. Spróbujmy jednak spojrzeć z tej strony:

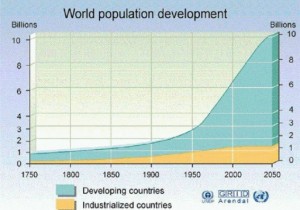

Stworzyliśmy po II wojnie światowej społeczeństwo konsumpcyjne, a liczba ludności raczej będzie się zwiększała. No właśnie, jakiej ludności? Tej z krajów rozwijających się, a nie rozwiniętych (przykład – grafika obok)[18]. Jeżeli nasza wiedza potęguje się co 8 lat, to jak bardzo w tyle stoją kraje afrykańskie? Ironio losu, to właśnie ludność z krajów rozwijających się będzie ponad ośmiokrotnie górowała nad ludnością krajów rozwiniętych, za jaki chcielibyśmy uważać Polskę.

Nasz rozwój stanie w miejscu. Kto stoi w miejscu, tak naprawdę cofa się.

Tym oto sposobem nabiliśmy się w butelkę.

Wydaje nam się, że jedyne, co może zniszczyć cywilizację postłacińską to wojna nuklearna, a tak naprawdę zagrożeniem są narastające wymagania, które stawiamy przed techniką (a jednocześnie zapominanie tradycyjnych metod radzenia sobie w trudnych sytuacjach – zupełnie jak w przykładzie z encyklopedią[19]) oraz pułapka konsumpcjonizmu przy malejącej liczbie ludności będącej w stanie nadgonić tempo które sama sobie ludzkość nadała.

Każda cywilizacja ma swój początek i koniec.

Być może potencjalnym rozwiązaniem jest zaprzestanie dotowania klasyczną pomocą humanitarną mieszkańców Afryki, a w zamian postawienie na cyfryzację? Im wcześniej ten proces zostanie rozpoczęty, tym większa szansa, że cywilizacja cyfrowa którą znamy przetrwa. Inaczej czeka nas kres nie tylko społeczeństwa informatycznego, ale i w ogóle społeczeństwa.

Wtedy znów zaczniemy porozumiewać się hieroglifami. W sumie znów zaczęliśmy…

[1] http://dziendobry.tvn.pl/wideo,2064,n/gutenberg-ryzojad-i-chajzer-stara-trufla,186439.html

[2] http://blog.oxforddictionaries.com/2015/11/word-of-the-year-2015-emoji/

[3] Znaki zaczerpnięte z https://pl.wikipedia.org/wiki/Pismo_hieroglificzne

[4] Jako przykład warto podać chociażby prawo Moore’a. http://www.dobreprogramy.pl/50-lat-Prawa-Moorea.-Ile-jeszcze-wykladniczego-postepu-przed-nami,News,62451.html

[5] http://www.biznes.newseria.pl/news/w_europie_brakuje,p976884552

[6] http://mobirank.pl/2015/11/23/wykorzystanie-mediow-przez-dzieci-raport-2015/

[7] http://pbi.org.pl/wystapienia/2014-11-25%20IAB%20Polska_AG_Profil%20u%C5%BCytkownika%20internetu%207-15.pdf

[8] http://www.bankier.pl/wiadomosc/W-Polsce-byl-PR-owcem-dzis-pokazuje-turystom-Lazurowe-Wybrzeze-Tam-mieszkam-7284247,2.html

[9] Było popularne z podobnego powodu co informatyka, szczególnie w PRL-u.

[10] https://spece.it/wydarzenia/targi-pracy-it-career-summit-2015-26-listopada-we-wroclawiu

[11] Tzn. nie będziemy wyszczególniać konkretnych grup zawodowych

[12] http://wyborcza.pl/1,75477,18817672,w-japonii-powieksza-sie-samotne-plemie.html

[13] http://mfiles.pl/pl/index.php/Śmierć_z_przepracowania oraz http://www.uzaleznieniabehawioralne.pl/index.php?option=com_content&view=article&id=273&Itemid=219

[14] Warto przejrzeć całą dyskusję w komentarzach, nie jest to jednostkowy przykład: http://www.dobreprogramy.pl/mordesku/Tworzenie-oprogramowania-dobrej-jakosci,57172.html

[15] Cytat z: http://ke.pcen.pl/rocznik-2012/item/187-antoni-zajac-cywilizacja-informacyjna-na-jezyk-kultury-wiedzy-i-edukacji-przetworzona

[16] Warto szczególnie zwrócić uwagę na szybko malejącą liczbę ludności w przedziale 10-14 i 15-19 co 10 lat (pierwsza tabela, plik Excela z archiwum Prognoza ludności na lata 2014-2050 – Polska dostępnego na http://demografia.stat.gov.pl/bazademografia/Prognoza.aspx)

[17] https://pl.wikipedia.org/wiki/Efekt_wąskiego_gardła

[18] http://ziemianarozdrozu.pl/encyklopedia/35/kwestia-skali

[19] Człowiek łatwo się przyzwyczaja do nowych i lepszych rzeczy i szybko porzuca stare, wolniejsze i mniej skuteczne metody. Wystarczy prosta obserwacja naszego otoczenia aby to potwierdzić – w innym przypadku odrzucilibyśmy chociażby telefony komórkowe.